一份完整的WordPress robots.txt 通用文件 屏蔽无效抓取页面

我们很多站长朋友使用WordPress程序的时候,肯定会忽略设置robots.txt文件。根据搜索引擎的文档我们可以看到robots.txt还是比较重要的,不过如果我们没有设置WordPress robots.txt,系统也会自动给一个默认的robots.txt文件,不过这个不是最好的。

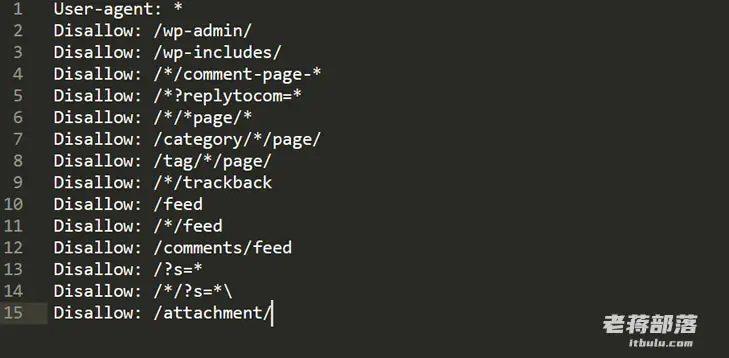

在这篇文章中,老蒋分享一个我们大家常用的可以屏蔽一些无效抓取的robots.txt文件,如果我们有需要可以根据实际在基础上设置增加。

User-agent: *Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /*/comment-page-*

Disallow: /*?replytocom=*

Disallow: /*/*page/*

Disallow: /category/*/page/

Disallow: /tag/*/page/

Disallow: /*/trackback

Disallow: /feed

Disallow: /*/feed

Disallow: /comments/feed

Disallow: /?s=*

Disallow: /*/?s=*\

Disallow: /attachment/

我们保存到我们的robots.txt文件中即可。

我们也可以根据自己的需要,如果有单独设置某些目录的,可以添加进来。

评论区(暂无评论)